FM - SYNTHESE

Ein japanischer Konzern, unter

anderem Hersteller elektronischer Tasteninstrumente, stellte seine neueste

Entwicklung neben der Elektrizität und dem Rad als eine der drei

fundamentalsten Erfindungen der Menschheitsentwicklung vor. Die Verkaufs-

Zahlen des Gerätes lassen fast die Vermutung zu, dass dieser Anspruch

nicht einmal zu hoch gegriffen ist. (red. Anmerkung: DX-7 von Yamaha)

Das Syntheseprinzip dieses angeblichen Geniestreiches

aus Fernost wird rätselhaft abgekürzt als FM-SYNTHESE bezeichnet,

ein Wunderwerk digitaler Spitzentechnologie.

Soweit die offizielle Lesart. FM steht schlicht und einfach für FREQUENZ-MODULATION,

also die Steuerung der Frequenz eines Tongenerators mit Hilfe einer, ebenfalls

tonfrequenten Schwingung eines zweiten Oszillators in diesem speziellen

Falle. Dieses Verfahren ist eigentlich einer der ältesten Hüte

der elektronischen Klangerzeugung und war schon bei Cage, Feldman und

Stockhausen in Verwendung als vom Synthesizer noch lange nicht die Rede

war. Selbst als dann Moog den analogen Synthesizer moderner Form populär

machte, blieb die Oszillator-Oszillator - Steuerung ein beliebtes Verfahren

zu Erzeugung von Glockenklängen, metallischem und ähnlich obertonreichen

Klängen.

Aufgrund der Ungenauigkeiten analoger Schaltungstechnik

war es jedoch bislang unmöglich, stabile Oszillatorkopplungen mit

mehr als drei VCOs zu realisieren. Digitale Steuerungstechnik ist nun

in der Lage die Stabilität einer beliebigen Anzahl von Oszillatoren

zu gewährleisten und genau da kommt die "neue" FM-Synthese

ins Spiel.

Je nach Geldbeutel, eine oder zwei Hände voll Sinus-Generatoren,

die, digital kontrolliert, zu verschiedenen Netzen aus Tonerzeugern und

Modulatoren verkoppelt werden können, das ist alles, was ein solches

"Supergerät” beinhaltet. Mit Hilfe von Hüllkurvengeneratoren

können nun Amplitude und Frequenz jedes Oszillators beeinflusst werden

damit auch eine dynamische Klangentwicklung möglich wird.

Wer sich das zu erwartende Resultat einer so durchgeführten

Synthese verdeutlichen will muss sich nur die Modulation einer sinusförmigen

Schwingung durch eine zweite Sinusgröße einmal genauer betrachten.

(besser noch mit normalen VCO ausprobieren)

Beispiel:

Oszillator 1 erzeugt eine Sinusschwingung der Frequenz 4000Hz. Er wird

von Oszillator 2 mit einer Sinusschwingung der Frequenz 500 Hz frequenzmoduliert.

Der modulierte Oszillator 1 liefert dann eine, aus drei Obertönen

bestehende, komplexe Wellenform. Die beiden Frequenzen der (außer

dem nach wie vor vorhandenen 4000Hz-Sinus), durch die Modulation entstandenen

Klanganteile entsprechen den Summen: (4000 + 500 * 4500 Hz) und der Differenzfrequenz

(4000 - 500 = 3500 Hz) der Einzelsinii (Modulator, Modulierter). Die Amplitude

dieser beiden neuen Obertöne ist gleich und hängt von der Amplitude

des Modulatorsignals ab.

Der Witz der FM- Synthese ist der, dass sich bei Verwendung mehrerer Oszillatoren

vielfältige, sehr Obertonreiche Spektren (sprich Klänge) mit

meist sehr geringer Amplitudendämpfung erzeugen lassen. Ein Instrument

mit ausschließlicher FM - Synthesemöglichkeit wird sich daher

durch eine Vielzahl metallischer, gläserner Klänge auszeichnen,

warme und weiche Klangcharaktere jedoch weitgehend vermissen lassen.

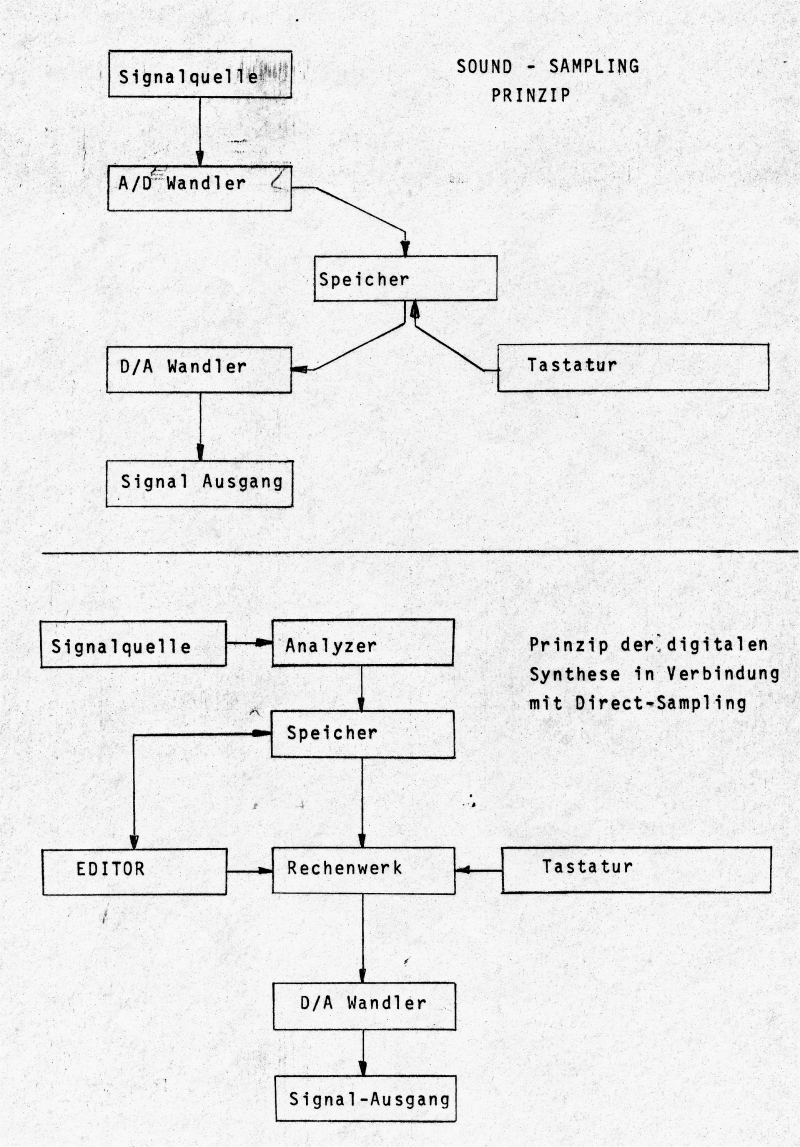

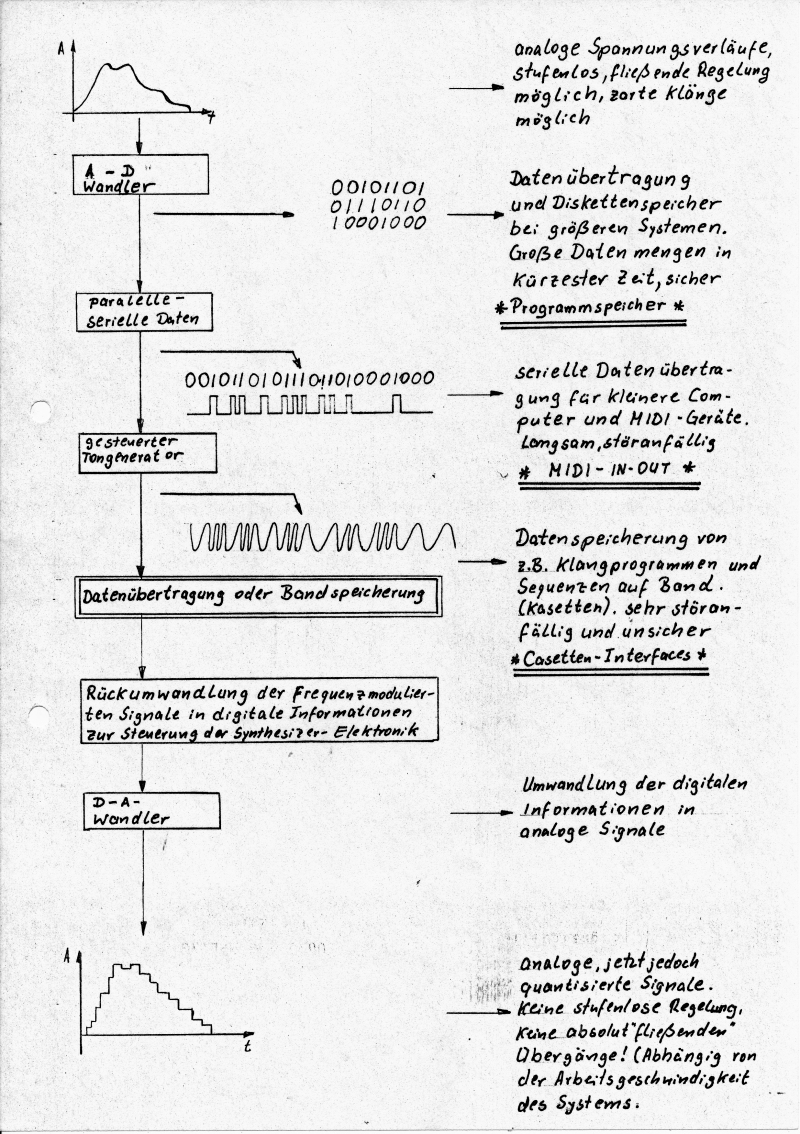

Grundlagen der digitalen Synthese

Es dürfte sich herumgesprochen haben, aber

egal, hier der Vollständigkeit halber noch einmal: Ein Klang, ob

Musikinstrument, Presslufthammer oder Brunftschrei eines Elches, ist

eine Schallschwingung mit einer charakteristischen Form (Wellenform).

Haben wir es mit einem unveränderlichen (statischen) Klang zu tun,

ist die Schwingungsform konstant. Für den Fall, dass sich die Klangfarbe

während des Verlaufs verändert (das ist meist der Fall), ändert

sich die Form der Schwingung fließend. Theoretisch existieren

damit auch in einem zeitlich begrenzten Klang (irgendwann geht dem Elch

ja mal die Luft aus) eine unendliche Zahl von Wellenformen. Aber wozu

bei der Synthese solcher Klangereignisse auf diese kleinen und kleinste

Veränderungen eingehen? Machen wir's wie beim Film, wir arbeiten

gerade so genau, dass das menschliche Wahrnehmungsvermögen den

Eindruck hat, es handele sich um einen Originalklang. Lassen wir zum

Beispiel einen Computer einen beliebigen Klang analysieren. Je nachdem,

wie lang der Klang ist (und wie schnell der Computer), gibt es unterschiedlich

viele "Momentan-Wellenformen". Umgekehrt werden aus diesen

diskreten Obertonspektren wieder Gesamtklänge. Je höher die

Zahl der Einzelspektren pro Zeiteinheit, desto originalgetreuer wirkt

der Klang. Man spricht hier von der Auflösung. Dieses Verfahren

nennt sich DIRECT - SAMPLING oder auch "Sound-Sampling". Mit

der digitalen Synthese hat es eigentlich noch nicht viel zu tun.

Um zu einer echten Synthetisierung von Klängen

in der Lage zu sein, erweitert man das einfache 'Aufnahme - Wiedergabe

- Computersystem' zum 'Aufnahme und Programmier- und Ausgabe - Computersystem'.

Um ein solches Gerät zu erstellen, sollte man sich jedoch tunlichst

erst einmal überlegen was es für Funktionsprinzipien gibt

und was sie zu leisten vermögen.

Synthese ?

Die Analyse eines Klanges liefert

eine Mischung von Sinuswellen (Obertöne). Diese bilden durch deren

unterschiedliche Frequenz und Amplituden das sogenannte Obertonspektrum

eines Klanges. Die Veränderung dieses Obertonspektrums über

einen gewissen Zeitraum, bildet dann einen dynamischen Klang."Schnappt”

man sich nun einen Stapel Sinusgeneratoren und stellt sie auf ein festes,

dem harmonischen Spektrum entsprechendes Frequenzverhältnis ein,

erhält man einen synthetisierten, statischen Klang. Steuert man

nun die Amplituden jedes einzelnen Generators mit Hilfe eines Computers

der die Informationen dazu ehemals dem Originalklang entnommen hat,

wird unser Klang sogar dynamisch, wir können es jetzt "Röhren"

lassen ohne dem Geweihträger auf den Pelz rücken zu müssen.

Für den Fall, dass es ein musikalischer Genuss werden soll, ermöglicht

man die parallele Verschiebung der Frequenz aller angesteuerten Sinusgeneratoren,

mittels einer Tastatur.

Um mit der digitalen Synthese gute Ergebnisse zu erringen braucht es

viel Programmiergefühl und noch mehr Zeit, dafür steht aber

dem Fleißigen die ganze Welt der Klänge offen und man sich

bestimmt für die nächsten 3 bis 4 Leben beschäftigen,

ohne sich zu wiederholen.(Hauptsache, der Strom fällt nicht aus...)

Diese Syntheseart, SINUSSYNTHESE oder ADDITIVE

SYNTHESE genannt, als direkte Umkehrung der Analyse nach FOURIER,

ist sicher der direkteste, aber auch aufwendigste Weg der Klangsynthese

für Musiker und Techniker.

Die Verfahren:

1) Die Hardwarelösung

Man baut wirklich für jeden gewünschten

Oberton einen Sinusoszillator mit kontrollierbarer Frequenz und einem

nachgeschalteten VCA zur Lautstärkenvariation in ein System ein.

Sämtliche Ausgänge der Oszillatoren führen über

einen Mixer zu den Ausgängen. Lautstärke- und Frequenzsteuerung

übernimmt der Computer. Woher er die, für die Arbeit notwendigen

Informationen erhält ist für die Synthese egal (Programm,

Tastatur, Sound-Sampling), wichtig ist nur, dass er sie hat und vor

allem schnell genug zur Verfügung stellt. Nun, dieses System ist

sehr schnell, durch die Vielzahl der Oszillatoren plus Steuerung aber

sehr aufwendig und teuer.

2). Die Software - Lösung

mittels virtueller Oszillatoren

Warum nicht den Computer die ganze Schwingung

erzeugen lassen? Warum nur seine Aufgaben auf das Steuern der Synthese

beschränken? Bei dieser Software-Lösung berechnet der Computer

jeden Obertonwert und das Resultat aller, dieser Werte. Er simuliert

also nur die, bei der Hardware-Lösung tatsächlich vorhandenen

Generatoren. Um diese Aufgabe bewältigen zu können, muss der

Rechner allerdings sehr viel schneller sein als im anderen Fall, die

Auflösung reicht sonst nicht mehr für die höherfrequenten

Obertöne. In diesem Modell wird der Rechner teuer, nicht die Peripherie.

Soweit die digitale Synthese für Puristen,

doch die Technik macht es einfacher, ausnahmsweise auch ohne die Möglichkeiten

zu verringern. Stichworte wie "Waveshaping"

und "Waveblending" - beide im

Zusammenhang mit sogenannten "Wavetables" verheißen

erleichterte Synthese in breitem Rahmen. Nichts desto trotz liefern

die großen Systeme auf Wunsch jeden einzelnen Oberton oder jedes

Momentanspektrum zum Verändern. Die Idee zum Wavetable entstand

schon bei den Sinus-Synthetikern (Software-Ecke) aus der Überlegung:

Warum den Sinus jedes Mal neu berechnen?... Wir machen das nur einmal,

speichern die Werte und haben sie immer zur

Verfügung wenn sie benötigt werden", (bei 64 Obertönen

ein gutes Argument) Der nächste Schritt: Warum legt man eigentlich

nicht gleich komplexe Wellenformen in einem Speicher ab, egal ob statische

oder dynamische?

Auf diese Weise bekommt man einen elektroakustischen

Baukasten, dessen Inhalt auf verschiedenste Art weiterverwendet werden

kann. Kaum sinnvoll ist es wohl, den Inhalt der "WAVETABLES"

unbearbeitet erklingen zu lassen, das Ergebnis dürfte recht langweilig

sein. Andererseits ist es jedoch überzogen, die Wavetable-Speicher

mit einer Unzahl komplexer Wellen zu füllen, die auch bei direkter

Ausgabe schon passabel klingen, denn dann handelte es sich bei dem Instrument

um einen Presetabspieler und nicht um einen Computer-Synthesizer. Also

gestalten wir die Inhalte der Wavetables so, dass wir eine große

Anzahl gut verwendbarer Grundschwingungsmuster bereit haben, bereit

für verschiedenartigste Verarbeitung mit dem Musik-Computer. Und

das ist nun der Moment, wo Waveshaping und Waveblending ins Spiel kommen.

Mit WAVESHAPING bezeichnet man alle Verfahren,

bei denen aus einer Basiswellenform (aus dem Wavetable) mit Hilfe von

Computerberechnungen eine, sich im Lauf einer bestimmten Zeit verändernde

Ausgangsschwingung gebildet wird. Man muss sich an dieser Stelle nochmals

vor Augen führen, dass eine solche Basisschwingung im Computerspeicher

als digitale Zahlenkolonne vorliegt. Mit dieser lässt man dann

den Computer, verschiedenen Programmen folgend, herumspielen. Meist

werden durch diese Waveshaping-Programme, mehr oder weniger komplexe

analoge Filterungen nachempfunden (PPG - WAVE). Allerdings findet man

in größeren Systemen auch "beliebige abstrakte Algorithmen.(Random-Sampling

beim PRISM).

Also nochmal in kurzen Worten: Wird nach beliebigen

Programmen aus einem Basis-Obertonspektrum eine Folge verschiedener

AusgangsSpektren gebildet (Berechnung), die nach D/A Wandlung eine dynamische,

komplexe Klangfolge ergeben, spricht man vom Waveshaping.(heißt

übersetzt übrigens "Wellenformung")

Beim WAVEBLENDING ist der Ursprung die

Erkenntnis, dass jede Klangentwicklung nach einigen, wenigen, bekannten

Gesetzmäßigkeiten verläuft. Sind einige dieser Verfahren

in Form eines Programms im Computer resident (vorhanden), reichen zwei

statische Wellenformen aus dem Wavetable (z.B. als Anfangs - und Endwelle)

um ein komplexes Klangmuster zu bilden. Sämtliche Übergangswellenformen

werden mit Hilfe des Übergangsprogrammes errechnet. Je mehr "Stützpunktwellen"

aus dem Wavetable verwendet werden, desto vielgestaltiger kann das Resultat

klingen. Diese Blending - Programme sind in der Regel einfacher gehalten

als Shaping - Programme, es kann im Extrem sogar auf eine einfache Lautstärkenüberblendung

reduziert werden. |

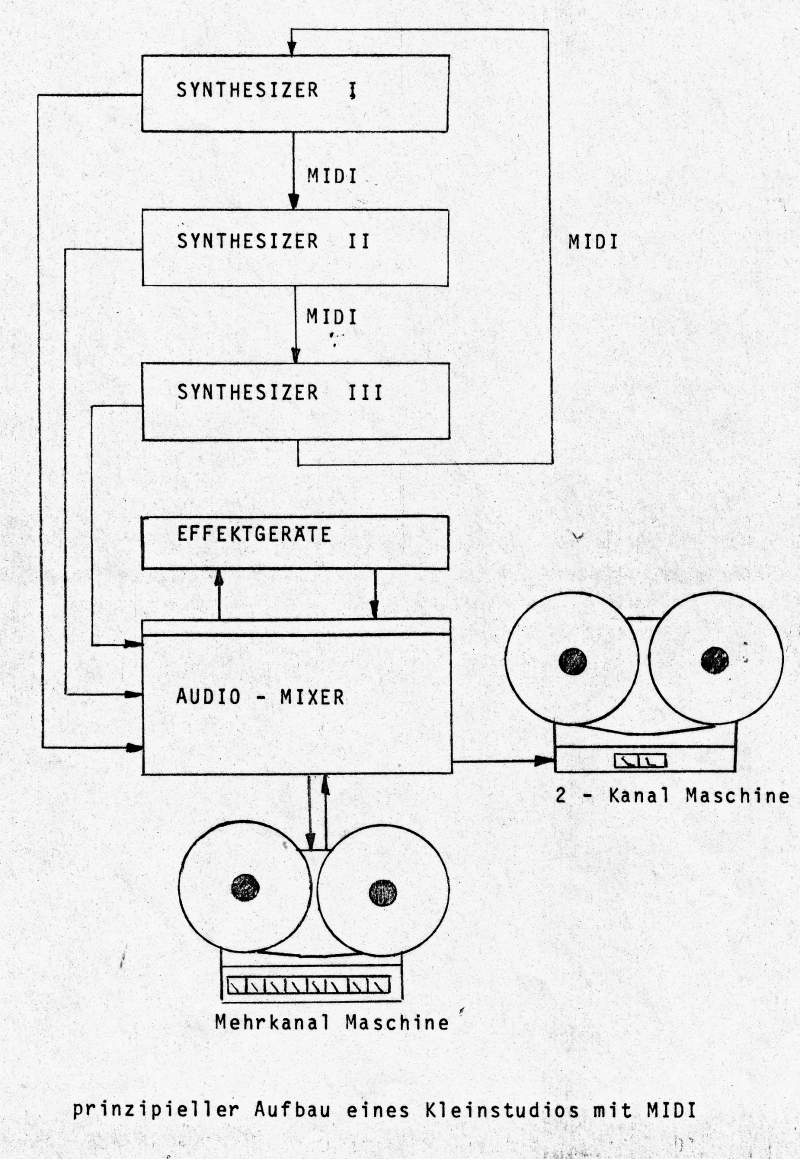

Einige Worte zum

MIDI - System

(Erinnerung: viele, heute selbstverständliche

Möglichkeiten waren damals nicht abzusehen)

MIDI ist,

wie wir alle wissen, keine neue Mode, welche die Rocklänge vorschreibt

sondern eine Abkürzung für: "Musical

Instrument Digital Interface". Dieses Interface ist eine,

halbwegs genormte Schnittstelle, mit deren Hilfe zwischen verschiedenen

Synthesizern, Computern und Rhythmusgeräten Daten ausgetauscht

werden können. Einige Geräte, die noch nicht über MIDI

verfügen, lassen sich nachrüsten. Die Bedingung allerdings

dazu ist, dass das Instrument von einem Mikroprozessor gesteuert wird

(intern). Einen Minimoog wird man daher nicht umrüsten können,

wohl aber alle programmierbaren Synthesizer und sogar Effektgeräte.

Durch die Anwendung von MIDI lassen sich z.B. mehrere Synthesizer

so miteinander koppeln, dass man auf einer Tastatur spielt, aber die

Klangerzeugungseinheiten aller angeschlossenen Geräte mit nutzt.

Aus zwei 6-stimmigen Geräten wird nun nicht gleich eine 12-Stimmige

Superkiste, die Sounds beider Synthesizer erklingen quasi parallel.

Die Anzahl der verfügbaren Stimmen und deren Optionen richten

sich nur nach der Tastatur, die man gerade benutzt, gehen aber natürlich

über die Anzahl der Stimmen des angeschlossenen Instrumentes

hinaus. Wenn man mit einer 8-stimmigen Tastatur einen 6-stimmigen

Synthesizer ansteuert, kann dieser natürlich nur mit 6 Stimmen

etwas anfangen. Schließt man nun aber an eine 6-stimmige Tastatur

einen 8 - Voice Synthesizer an, bleibt es bei den eben erwähnten

6 Stimmen weil die Tastatur in diesem Falle nicht mehr verarbeiten

kann. Ebenso verhält es sich mit Anschlagdynamik und anderen

Optionen. Klar ?? Es zählt hier, wie so oft, das schwächste

Glied in der Kette. Mit der SYNCHRONISATION von Rhythmuscomputern

und Sequenzern gibt es solche Schwierigkeiten nicht, Impuls bleibt

Impuls - und mehr braucht MIDI in diesen Fällen eigentlich nicht

zu übertragen.

Unsere Meinung:

So ganz zufrieden sind wir nicht mit der Einführung des MIDI

- Systems, es gibt da doch einige, nicht korrigierbare Schwachstellen.

(diese Meinung teilen vor allem Leute mit uns, die sich etwas besser

mit Computern auskennen)

MIDI wird von der Industrie als zukunftssicher und stets erweiterbar

angepriesen, doch schon heute gibt es eine ganze Reihe von Instrumenten,

bei denen es nicht möglich ist, MIDI zu nutzen. (DSX - Sequenzer,

Rhodes-Chroma, einige Rhythmuscomputer usw.) Grund dafür ist

nicht die Eigenbrötelei der Hersteller, sondern die Tatsache,

dass man sich mit MIDI auf die langsamste Art der Datenübertragung

überhaupt geeinigt hat. Die Daten werden seriell übertragen,

d.h. wie auf eine Perlenkette aufgezogen und dann "gesendet".

Nun wächst aber mit fortschreitender Entwicklung der Instrumente

gerade auf dem Gebiet der Synthesizer die anfallende Datenmenge mit

der Qualität der Instrumente und deren Bedienungsvielfalt. Immer

mehr und immer schneller werden Daten erzeugt und müssen bearbeitet

werden und genau da steht MIDI hilflos dem “Ansturm" gegenüber.

Die Hersteller hätten sich stattdessen

lieber auf ein sogenanntes Parallel-Interface einigen sollen, das

naturgemäß wesentlich leistungsfähiger und flexibler

ist. Wahrscheinlich war es aber den Anbietern zu aufwendig - das MIDI

Interface gibt es fast als ABFALLPRODUKT automatisch bei allen digital

gesteuerten Instrumenten.

Kosten und Nutzen von MIDI

Wer sein Instrument gerne mit

Hilfe eines Computers Steuern möchte, benötigt dazu zunächst

einmal einen Computer mit einigermaßen vernünftiger Ausstattung,

ein MIDI-Computer-Interface, entsprechende Software und last-not least,

einige Erfahrung im Umgang mit Computern im Allgemeinen.

Immer wieder heißt es, MIDI - Computer -Programme ersetzen eine

Mehrkanal Tonbandmaschine ....doch das ist nur ein listiges Verkaufsargument

des Handels. Wer sollte denn, bitteschön die Abmischung mit den

diffizilen Lautstärken und den Effektgeräteinspielungen

erledigen - auch ein Computer?? Das MIDI ist fraglos bestens geeignet

als "Super-Maxi - Multi Sequenzer" und zeigt in Zusammenarbeit

mit einem Computer seine Leistungsfähigkeit. Nachdem man seine

Musik komponiert und diese dann in den Computer "getickert"

hat, kann man nun selbstverständlich seine Synthesizer und seine

Diskette mit dem Programm für deren Steuerung unter den Arm klemmen

und in

ein großes Tonstudio marschieren um sie dort ohne langwierige

Proben einzspielen. Durch den Wegfall nervender Verspieler

und ähnlicher Probleme spart man bei dieser Aktion viel Zeit

und damit Geld.

Wer jedoch nur für den Eigenbedarf komponiert,

der ist besser mit einer Mehrkanal-Maschine beraten, denn so ein Computersystem

kostet ein Haufen Geld.

Man sollte sich das vorher genau überlegen und durchrechnen,

ob nicht ein zweites Instrument sinnvoller ist.

|